机器学习笔记-Logistic Regression

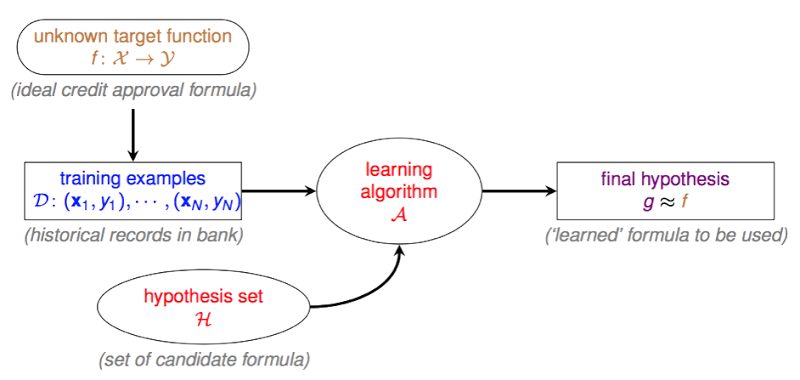

笔记整理自台大林轩田老师的开放课程-机器学习基石,笔记中所有图片来自于课堂讲义。

上一篇比较深入地去理解了线性回归的思想和算法。分类和回归是机器学习中很重要的两大内容。而本篇要讲的Logistic Regression,名字上看是回归,但实际上却又和分类有关。

之前提过的二元分类器如PLA,其目标函数为, $f(x)=sign(w^Tx)\in{-1,+1}$,输出要么是-1要么是+1,是一个“硬”的分类器。而Logistic Regression是一个“软”的分类器,它的输出是$y=+1$的概率,因此Logistic Regression的目标函数是 $\color{purple}{f}(x)=\color{orange}{P(+1|x)}\in [0,1]$。